In der Welt der Softwareentwicklung gibt es verschiedene Programmierparadigmen, die jeweils ihre eigenen Ansätze und Philosophien zur Lösung von Problemen bieten. Zwei der prominentesten Paradigmen sind die objektorientierte Programmierung (OOP) und die funktionale Programmierung (FP). OOP basiert auf der Idee, dass Software aus Objekten besteht, die sowohl Daten als auch Funktionen kapseln.

Diese Objekte interagieren miteinander, um komplexe Systeme zu bilden. Im Gegensatz dazu konzentriert sich FP auf die Verwendung von Funktionen als zentrale Bausteine der Programmierung. Hierbei werden Funktionen als erstklassige Objekte behandelt, was bedeutet, dass sie wie Daten behandelt und an andere Funktionen übergeben werden können.

Die Wahl zwischen OOP und FP hat weitreichende Auswirkungen auf die Softwarearchitektur, die Wartbarkeit des Codes und die Effizienz der Entwicklung. Während OOP oft intuitiv erscheint, da es sich an der realen Welt orientiert, bietet FP eine mathematische Strenge und eine klare Trennung von Zuständen und Effekten. Diese Unterschiede führen zu unterschiedlichen Ansätzen bei der Problemlösung und erfordern von Entwicklern, sich mit den jeweiligen Paradigmen vertraut zu machen, um die Vorteile und Herausforderungen beider Ansätze zu verstehen.

Key Takeaways

- OOP und FP sind zwei verschiedene Programmierparadigmen, die sich in ihrer Herangehensweise an die Softwareentwicklung unterscheiden.

- Die Grundprinzipien von OOP umfassen Klassen, Objekte, Vererbung, Polymorphismus und Abstraktion.

- Die Grundprinzipien von FP beinhalten Funktionen als Erstklassige Bürger, Unveränderlichkeit, Funktionale Komposition und Rekursion.

- OOP und FP können anhand von Codebeispielen wie Klassen und Vererbung in OOP und Funktionen und Unveränderlichkeit in FP verglichen werden.

- Vorteile von OOP sind unter anderem Wiederverwendbarkeit von Code, Modellierung der realen Welt und einfache Wartbarkeit.

Die objektorientierte Programmierung beruht auf mehreren grundlegenden Prinzipien, die ihre Struktur und Funktionsweise definieren. Eines der zentralen Konzepte ist das Prinzip der Kapselung. Kapselung bedeutet, dass die Daten eines Objekts und die darauf operierenden Methoden in einer Einheit zusammengefasst werden.

Dies ermöglicht es, den internen Zustand eines Objekts vor unbefugtem Zugriff zu schützen und nur über definierte Schnittstellen (Methoden) darauf zuzugreifen. Ein Beispiel hierfür ist eine Klasse „Auto“, die Attribute wie „Geschwindigkeit“ und „Farbe“ sowie Methoden wie „beschleunigen“ und „bremsen“ enthält. Der Benutzer kann nur über diese Methoden auf die Attribute zugreifen, was die Integrität des Objekts gewährleistet.

Ein weiteres wichtiges Prinzip der OOP ist die Vererbung. Vererbung ermöglicht es einer Klasse, Eigenschaften und Methoden einer anderen Klasse zu übernehmen. Dies fördert die Wiederverwendbarkeit von Code und erleichtert die Erweiterung bestehender Systeme.

Zum Beispiel könnte eine Klasse „Fahrzeug“ eine Basisklasse sein, von der spezifische Klassen wie „Auto“ und „Motorrad“ abgeleitet werden. Diese abgeleiteten Klassen erben die allgemeinen Eigenschaften des Fahrzeugs, können jedoch auch spezifische Merkmale hinzufügen oder bestehende Methoden überschreiben. Durch diese Hierarchie wird eine klare Struktur geschaffen, die das Verständnis und die Wartung des Codes erleichtert.

Grundprinzipien von FP

Die funktionale Programmierung basiert auf einer Reihe von Prinzipien, die sich stark von denen der OOP unterscheiden. Ein zentrales Konzept ist die Unveränderlichkeit von Daten. In der FP werden Datenstrukturen nicht verändert; stattdessen werden neue Datenstrukturen aus bestehenden erstellt.

Dies führt zu einem klareren und vorhersagbareren Verhalten des Codes, da Funktionen keine Nebeneffekte haben, die den Zustand des Programms beeinflussen könnten. Ein Beispiel für Unveränderlichkeit ist die Verwendung von Listen in einer funktionalen Sprache wie Haskell, wo anstelle der Modifikation einer Liste eine neue Liste zurückgegeben wird, die das gewünschte Element enthält. Ein weiteres fundamentales Prinzip der funktionalen Programmierung ist die Verwendung von höheren Funktionen.

Höhere Funktionen sind Funktionen, die andere Funktionen als Argumente akzeptieren oder Funktionen zurückgeben. Dies ermöglicht eine hohe Flexibilität und Modularität im Code. Ein Beispiel hierfür ist eine Funktion „map“, die eine Funktion auf jedes Element einer Liste anwendet und eine neue Liste mit den Ergebnissen zurückgibt.

Diese Art der Abstraktion fördert einen deklarativen Stil der Programmierung, bei dem der Fokus auf dem „Was“ anstatt auf dem „Wie“ liegt.

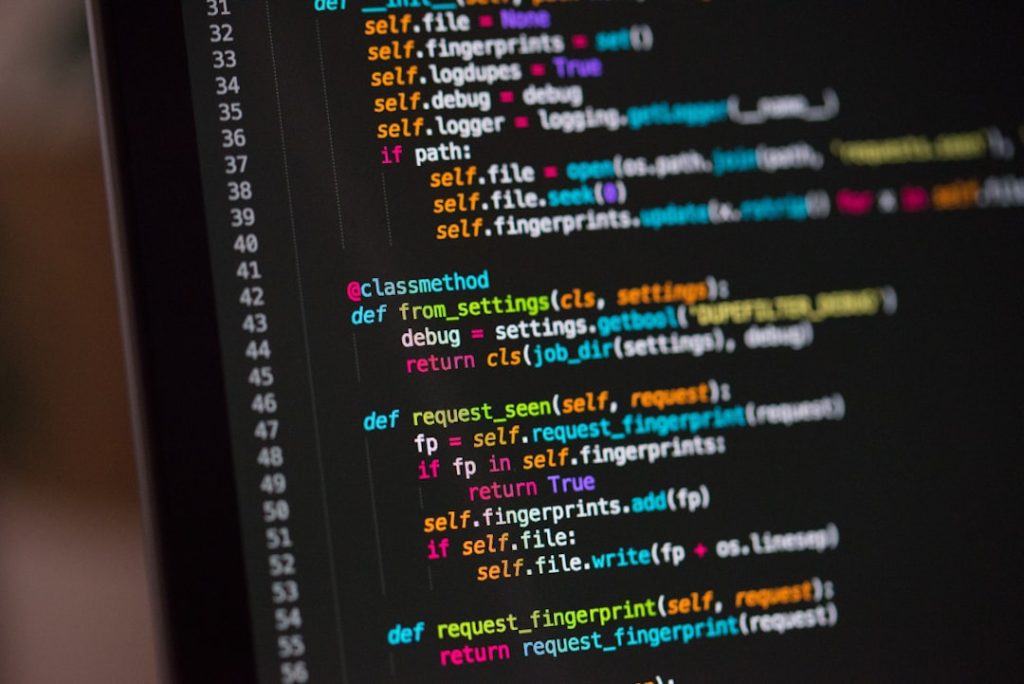

Vergleich von OOP und FP anhand von Codebeispielen

Um die Unterschiede zwischen OOP und FP zu verdeutlichen, betrachten wir ein einfaches Beispiel zur Berechnung der Summe einer Liste von Zahlen. In einer objektorientierten Sprache wie Java könnte dies folgendermaßen aussehen: „`java

class SumCalculator {

private List

this.numbers = numbers;

} public int calculateSum() {

int sum = 0;

for (int number : numbers) {

sum += number;

}

return sum;

}

}

„` In diesem Beispiel wird eine Klasse „SumCalculator“ definiert, die eine Liste von Zahlen kapselt und eine Methode zur Berechnung der Summe bereitstellt. Die Kapselung der Daten innerhalb der Klasse ermöglicht es, den Zustand der Liste zu schützen und nur über definierte Methoden darauf zuzugreifen.

Im Gegensatz dazu könnte dasselbe Problem in einer funktionalen Sprache wie Haskell so gelöst werden: „`haskell

sumList :: [Int] -> Int

sumList numbers = foldl (+) 0 numbers

„` Hier wird eine Funktion „sumList“ definiert, die eine Liste von Ganzzahlen als Eingabe erhält und die Summe berechnet, indem sie die Funktion „foldl“ verwendet, um über die Liste zu iterieren. Es gibt keine Klassen oder Objekte; stattdessen wird der Fokus auf die Funktionalität gelegt.

Vorteile von OOP gegenüber FP

Die objektorientierte Programmierung bietet mehrere Vorteile, insbesondere in Bezug auf die Strukturierung komplexer Systeme. Ein wesentlicher Vorteil ist die intuitive Modellierung realer Probleme durch Objekte. Entwickler können Konzepte aus der realen Welt direkt in den Code übertragen, was das Verständnis und die Kommunikation zwischen Teammitgliedern erleichtert.

Diese Nähe zur Realität macht OOP besonders geeignet für Anwendungen mit komplexen Interaktionen zwischen verschiedenen Entitäten. Ein weiterer Vorteil ist die Wiederverwendbarkeit von Code durch Vererbung und Polymorphismus. Entwickler können bestehende Klassen erweitern oder anpassen, ohne den gesamten Code neu schreiben zu müssen.

Dies spart Zeit und Ressourcen bei der Entwicklung neuer Funktionen oder Module innerhalb eines Systems. Zudem ermöglicht Polymorphismus das Erstellen von generischen Algorithmen, die mit verschiedenen Datentypen arbeiten können, was die Flexibilität des Codes erhöht.

Vorteile von FP gegenüber OOP

Die funktionale Programmierung bringt ebenfalls zahlreiche Vorteile mit sich, insbesondere in Bezug auf Wartbarkeit und Testbarkeit des Codes. Da FP auf unveränderlichen Datenstrukturen basiert und Funktionen keine Nebeneffekte haben, ist der Code oft einfacher zu verstehen und vorherzusagen. Dies führt zu weniger Fehlern und erleichtert das Testen einzelner Funktionen unabhängig vom Rest des Systems.

Ein weiterer Vorteil ist die Möglichkeit zur Parallelisierung. Da Funktionen in der FP unabhängig sind und keine gemeinsamen Zustände teilen, können sie leicht parallel ausgeführt werden. Dies ist besonders vorteilhaft in modernen Anwendungen, wo Multithreading und parallele Verarbeitung zunehmend wichtig sind, um Leistung und Effizienz zu maximieren.

Die Fähigkeit, Aufgaben parallel auszuführen, kann signifikante Leistungsgewinne bringen, insbesondere bei rechenintensiven Anwendungen.

Anwendungsbereiche von OOP und FP

Die Wahl zwischen OOP und FP hängt stark vom Anwendungsbereich ab. Objektorientierte Programmierung findet häufig Anwendung in großen Softwareprojekten, bei denen komplexe Datenstrukturen und Interaktionen zwischen verschiedenen Komponenten erforderlich sind. Beispiele hierfür sind Unternehmensanwendungen, Spieleentwicklung oder grafische Benutzeroberflächen (GUIs), wo das Modellieren von Objekten aus der realen Welt entscheidend ist.

Funktionale Programmierung hingegen wird oft in Bereichen eingesetzt, in denen mathematische Berechnungen oder Datenverarbeitung im Vordergrund stehen. Anwendungen wie Datenanalyse, maschinelles Lernen oder Webentwicklung profitieren von den Vorteilen der FP, insbesondere wenn es um hohe Parallelität oder unveränderliche Datenstrukturen geht. Programmiersprachen wie Scala oder Elixir kombinieren oft beide Paradigmen und ermöglichen Entwicklern, je nach Bedarf zwischen OOP- und FP-Ansätzen zu wechseln.

Fazit: Welches Programmierparadigma ist besser?

Die Frage nach dem besseren Programmierparadigma – OOP oder FP – lässt sich nicht pauschal beantworten, da beide Ansätze ihre eigenen Stärken und Schwächen haben. Die Wahl hängt stark vom spezifischen Anwendungsfall sowie den Vorlieben des Entwicklungsteams ab. Während OOP durch ihre intuitive Strukturierung komplexer Systeme besticht, bietet FP Vorteile in Bezug auf Wartbarkeit und Parallelisierung.

Letztlich sollten Entwickler sowohl OOP als auch FP verstehen und in der Lage sein, je nach Anforderungen des Projekts das geeignete Paradigma auszuwählen oder sogar beide Ansätze zu kombinieren. In einer zunehmend komplexen Softwarelandschaft ist Flexibilität entscheidend für den Erfolg eines Projekts.

Es gibt viele Diskussionen darüber, welches Programmierparadigma besser ist: objektorientierte Programmierung (OOP) oder funktionale Programmierung (FP). Ein interessanter Artikel, der sich mit diesem Thema befasst, ist „Was ist eine Rechnungssoftware: Rechnungseingang“. In diesem Artikel werden die Vor- und Nachteile von OOP und FP diskutiert und wie sie sich auf die Entwicklung von Software auswirken können. Es ist wichtig, die Unterschiede zwischen den beiden Paradigmen zu verstehen, um fundierte Entscheidungen bei der Softwareentwicklung treffen zu können.